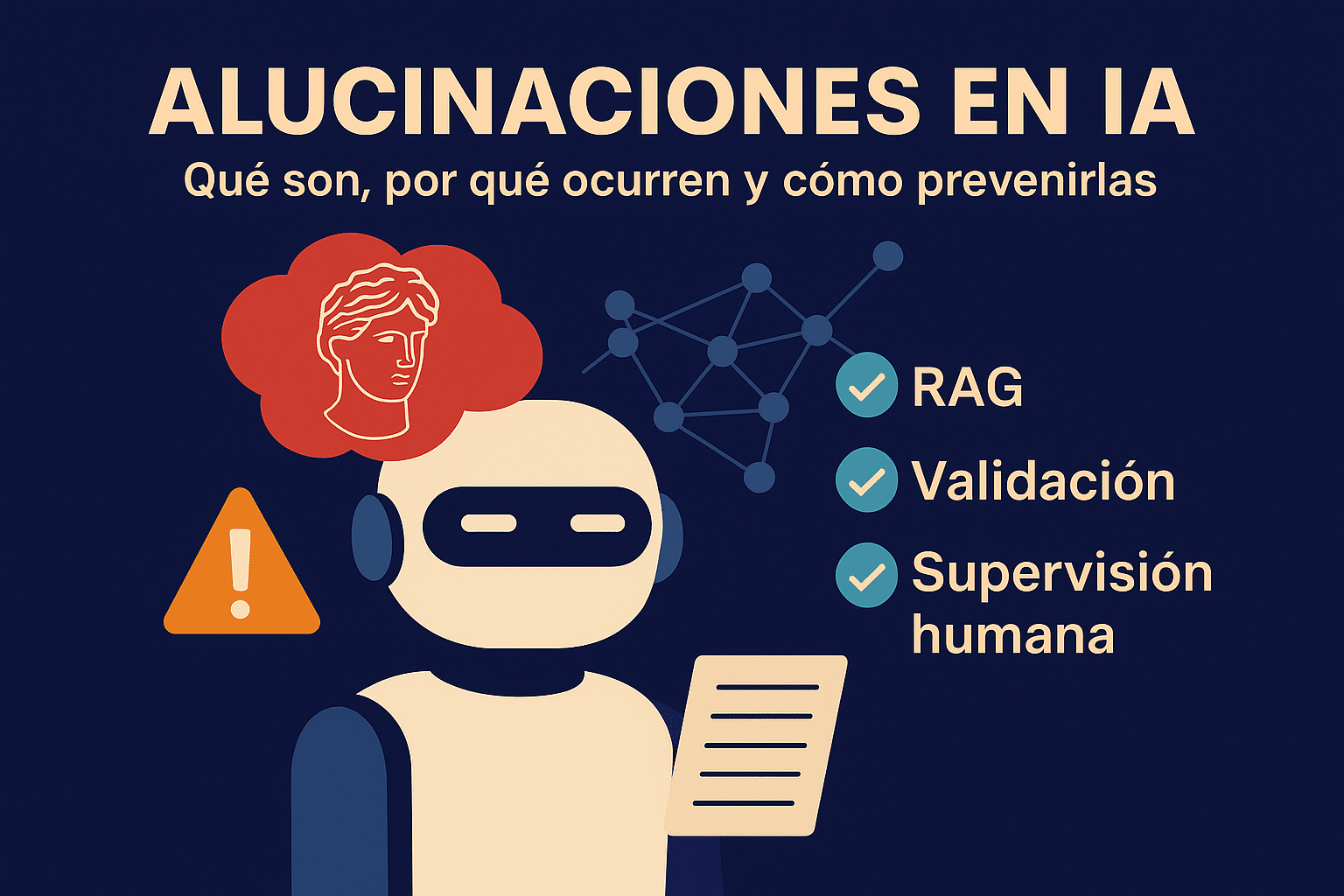

Alucinaciones en inteligencia artificial: qué son, por qué ocurren y cómo prevenirlas

Tiempo estimado de lectura: 7 minutos

Las alucinaciones en inteligencia artificial no son ciencia ficción: son esos momentos en los que un modelo de IA se inventa datos, citas o casos con total seguridad. En esta guía te explico, de forma clara y sin drama, qué son, por qué ocurren y cómo reducir este riesgo si estás usando agentes de IA en tu negocio.

Puntos Clave

- Las alucinaciones en inteligencia artificial son respuestas incorrectas o inventadas que suenan convincentes pero no se basan en hechos reales.

- No son “bugs raros”, sino un comportamiento esperable si los modelos generativos se usan sin límites, sin buenos datos o sin controles.

- Tienen impacto real: pérdida de confianza, riesgos legales, decisiones erróneas y daños reputacionales.

- El informe The State of AI 2024 de McKinsey indica que el 44% de las organizaciones que usan gen AI ha sufrido consecuencias negativas, con la inexactitud entre los riesgos más citados (fuente).

- Se pueden reducir de forma drástica combinando RAG, validación automática, guardrails, supervisión humana y un diseño responsable de agentes.

- Con regulaciones como la EU AI Act, las empresas deben tratar las alucinaciones como un riesgo de cumplimiento, no como una simple rareza técnica.

Tabla de Contenidos

- 1. Qué son las alucinaciones en inteligencia artificial (explicado fácil)

- 2. Por qué ocurren: cómo “piensa” realmente un modelo

- 3. Impacto real en empresas y casos documentados

- 4. Cómo detectar alucinaciones en tus agentes

- 5. 7 estrategias clave para reducir alucinaciones (tabla)

- 6. RAG: el aliado imprescindible contra las alucinaciones

- 7. Buenas prácticas para equipos y empresas

- 8. Contexto legal y responsabilidad en 2025

- 9. Preguntas frecuentes

- 10. Últimas entradas en AgentzIA

1. Qué son las alucinaciones en inteligencia artificial (explicado fácil)

Una alucinación en IA ocurre cuando un modelo como ChatGPT, Claude o Gemini responde con total seguridad algo que suena bien… pero es falso. Nombres inventados, citas que no existen, cifras equivocadas, enlaces que no llevan a ningún sitio. Tú lo lees y piensas: “esto cuadra”. Pero no cuadra.

No es mala fe. El modelo no “quiere engañar”. Su función no es garantizar verdad, sino generar la siguiente palabra más probable. Si no tiene contexto suficiente o el sistema le deja hablar de todo sin límites, rellena huecos. Y ahí es donde las cosas se tuercen.

2. Por qué ocurren: cómo “piensa” realmente un modelo

Un modelo de lenguaje grande (LLM) no consulta una base de datos en vivo ni hace búsquedas en internet en cada respuesta (a menos que lo conectes para ello). Simplificando mucho, funciona así:

- Lee tu mensaje y el contexto previo.

- Calcula qué secuencia de palabras encaja mejor estadísticamente.

- Genera una respuesta plausible según patrones aprendidos en el entrenamiento.

La investigación reciente sobre alucinaciones en inteligencia artificial muestra que incluso los modelos más avanzados mantienen tasas de error factual. Dependen del tipo de tarea, del dominio y de cómo se orquesta el sistema. Si no conectas el agente a fuentes fiables ni delimitas su rol, es cuestión de tiempo que “se invente” algo crítico. Para una visión técnica puedes revisar “A Survey on Hallucination in LLMs” o “Factuality of Large Language Models”.

3. Impacto real en empresas y casos documentados

Cuando usas IA por curiosidad, una alucinación es una anécdota. En una empresa, puede traducirse en reclamaciones, titulares o sanciones.

- Casos legales: en Mata v. Avianca (2023), dos abogados fueron sancionados con 5.000 dólares por presentar sentencias inexistentes generadas con IA sin verificarlas (fuente).

- Contenido público: medios y plataformas han retirado artículos generados con IA por contener datos falsos o citas fabricadas.

- Atención al cliente: bots que prometen políticas, descuentos o condiciones que la empresa nunca aprobó.

- Negocio interno: informes con métricas incorrectas que se usan para tomar decisiones reales.

No es ciencia ficción. Es el día a día de muchas compañías que han integrado IA generativa sin pensar en cómo controlar sus salidas.

4. Cómo detectar alucinaciones en tus agentes

Buenas noticias: hay señales bastante claras de que tu agente está “alucinando”.

- Respuestas muy concretas sin citar fuentes ni contexto.

- Contradicciones al repetir la misma pregunta con ligeras variaciones.

- Datos demasiado “perfectos” sin explicación (porcentajes redondos, fechas exactas siempre).

- Menciones a leyes, estudios, URLs o sentencias que nadie consigue localizar.

En producción, no puedes esperar a que el usuario detecte esto por instinto. El sistema debe ayudar a identificar y frenar posibles alucinaciones antes de que generen daño.

5. 7 estrategias clave para reducir alucinaciones (tabla práctica)

No existe el botón mágico de “0% errores”, pero sí hay formas muy claras de reducirlos al mínimo.

| Estrategia | Descripción | Cuándo aplicarla |

|---|---|---|

| 1. RAG (Retrieval Augmented Generation) | El modelo consulta tus documentos y bases de datos en tiempo real y genera la respuesta apoyándose en ese contenido, reduciendo invenciones. | FAQs, políticas, fichas de producto, documentación técnica, conocimiento interno. |

| 2. Restringir el rol del agente | Definir con precisión qué puede y qué no puede responder. Menos terreno = menos espacio para alucinar. | Asistentes de soporte, reservas, helpdesk, backoffice. |

| 3. Pedir fuentes y nivel de confianza | Obligar al agente a indicar de dónde saca la información o marcar cuando la confianza es baja. | Legal, médico, financiero, analítica crítica. |

| 4. Validación automática | Cruzar datos con APIs, ERPs o CRMs antes de mostrarlos (precios, stock, plazos, importes). | eCommerce, logística, banca, reservas, cualquier dato sensible. |

| 5. Segundo modelo como revisor | Usar un “agente auditor” que revise la respuesta del principal, detecte incoherencias y fuerce correcciones. | Casos de alto impacto económico o reputacional. |

| 6. Human-in-the-loop | Definir cuándo una persona debe revisar o aprobar la respuesta antes de enviarla. | Salud, legal, crédito, seguros, comunicaciones públicas sensibles. |

| 7. Monitorizar y aprender de errores | Registrar casos problemáticos y ajustar prompts, reglas, fuentes y configuración. | Cualquier sistema en producción con tráfico real. |

Cuando combinas estas piezas con un buen diseño de agentes, las alucinaciones en inteligencia artificial dejan de ser una ruleta rusa y pasan a ser un riesgo gestionado.

6. RAG: el aliado imprescindible contra las alucinaciones

RAG (Retrieval Augmented Generation) es, probablemente, la herramienta más importante hoy para construir agentes confiables.

En lugar de confiar solo en lo que “recuerda” el modelo:

- Busca en tus documentos, wikis internas, bases de datos o repositorios verificados.

- Selecciona los fragmentos relevantes.

- Genera la respuesta apoyándose en ese contenido, no en suposiciones.

En sectores sensibles, es la diferencia entre un asistente simpático y un sistema que puedes enseñar en un comité de riesgos sin sudar.

7. Buenas prácticas para equipos y empresas

- Define el caso de uso y el alcance del agente antes de elegir modelo.

- Conecta el agente a fuentes internas actualizadas y controladas.

- Permite que el sistema diga “no tengo datos suficientes” en vez de inventar.

- Implementa revisión humana donde una respuesta incorrecta pueda causar daño.

- Mide: errores detectados, escalados a humano, feedback de usuarios, etc.

8. Contexto legal y responsabilidad en 2025

La EU AI Act y otras normativas dejan claro que “lo dijo la IA” no es excusa. Si tu empresa usa sistemas de IA para informar, recomendar o decidir, sigues siendo responsable del resultado.

- Obligación de informar al usuario cuando interactúa con una IA.

- Requisitos de trazabilidad, supervisión y gestión de riesgos en sistemas de alto impacto.

- Expectativa de controles razonables para evitar daños por salidas engañosas.

9. Preguntas frecuentes

¿Se pueden eliminar por completo las alucinaciones en inteligencia artificial?

No al 100%. Pero con RAG, validación, límites claros y supervisión humana se pueden reducir a niveles muy bajos y aceptables para la mayoría de usos.

¿La IA “miente” cuando alucina?

No actúa con intención. Completa patrones. Por eso es clave permitirle decir “no lo sé” y diseñar el sistema para que no responda fuera de su ámbito.

¿Es buena idea usar un agente de IA en atención al cliente?

Sí, siempre que trabaje con información oficial, conectada a tus sistemas, y puedas escalar fácil a una persona cuando la consulta lo requiera.

¿Cuándo es obligatorio tener revisión humana?

Siempre que una respuesta pueda impactar en salud, reputación, dinero de clientes o cumplimiento normativo. Ahí la IA ayuda, pero no decide sola.