Cómo diseñar un agente de IA sin convertirlo en una caja negra

Tiempo estimado de lectura: 8 minutos

Puntos clave

- Un agente de IA no debería tomar decisiones que no puedas explicar

- La mayoría de cajas negras se crean por mal diseño, no por la IA

- Arquitectura simple no significa arquitectura pobre

- Las reglas y límites son tan importantes como el modelo

- Diseñar bien evita problemas legales, operativos y de confianza

Tabla de contenidos

- Introducción

- Qué significa que un agente sea una caja negra

- Por qué muchos agentes acaban siendo cajas negras

- La arquitectura mínima para mantener control

- Reglas y límites: la parte menos glamurosa

- El humano en el bucle

- Ejemplo conceptual de diseño

- Preguntas frecuentes

- Conclusión

Introducción

Uno de los mayores miedos alrededor de los agentes de IA no es que fallen.

Es no entender por qué hacen lo que hacen.

Cuando un sistema toma decisiones sin que nadie pueda explicarlas con claridad, aparece lo que muchos llaman “caja negra”.

En la mayoría de casos, ese problema no viene del modelo de IA, sino del diseño del agente.

Qué significa que un agente sea una caja negra

Un agente se convierte en una caja negra cuando:

- No está claro qué datos usa para decidir

- No se sabe qué reglas sigue

- No queda registro de por qué actúa de una forma u otra

- No hay límites explícitos a su comportamiento

Esto genera desconfianza, incluso aunque el agente “funcione”.

Un sistema opaco puede ser eficiente… hasta que deja de serlo.

Por qué muchos agentes acaban siendo cajas negras

Hay varios patrones que se repiten:

- Empezar por la herramienta en lugar del diseño

- No definir reglas claras antes de usar IA

- Confiar en prompts en lugar de arquitectura

- Mezclar demasiadas tareas en un solo agente

El resultado suele ser un sistema difícil de mantener y aún más difícil de explicar.

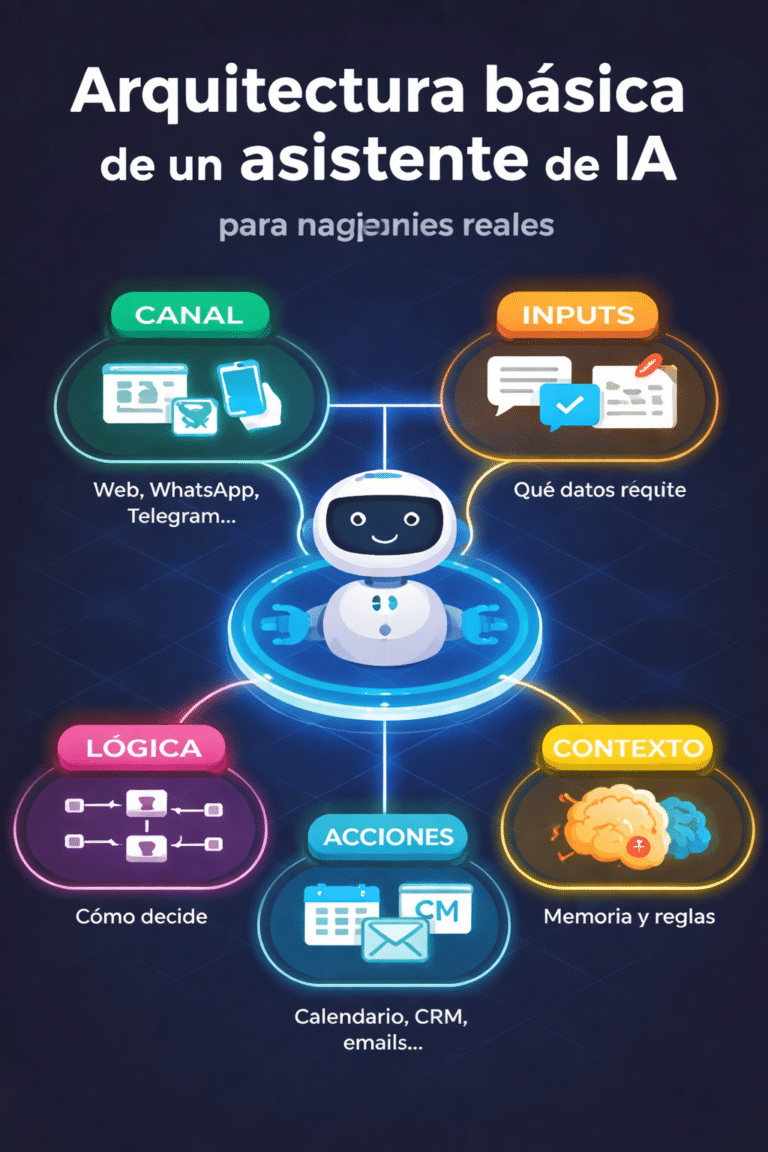

La arquitectura mínima para mantener control

Diseñar un agente no es construir algo complejo, sino algo claro.

Una arquitectura mínima suele incluir:

- Un canal claro (dónde vive el agente)

- Inputs bien definidos

- Reglas explícitas antes de usar IA

- Acciones limitadas

- Registro de decisiones

Cada pieza reduce ambigüedad.

Reglas y límites: la parte menos glamurosa

Los límites son lo que convierte a un agente en un sistema fiable.

Definir qué NO puede hacer el agente es tan importante como definir qué sí puede hacer.

Sin límites claros, cualquier agente acaba improvisando.

El humano en el bucle

Incluir a una persona en determinados puntos del flujo no es una debilidad.

Es una decisión de diseño.

El humano permite:

- Resolver excepciones

- Asumir responsabilidad

- Mejorar reglas con el tiempo

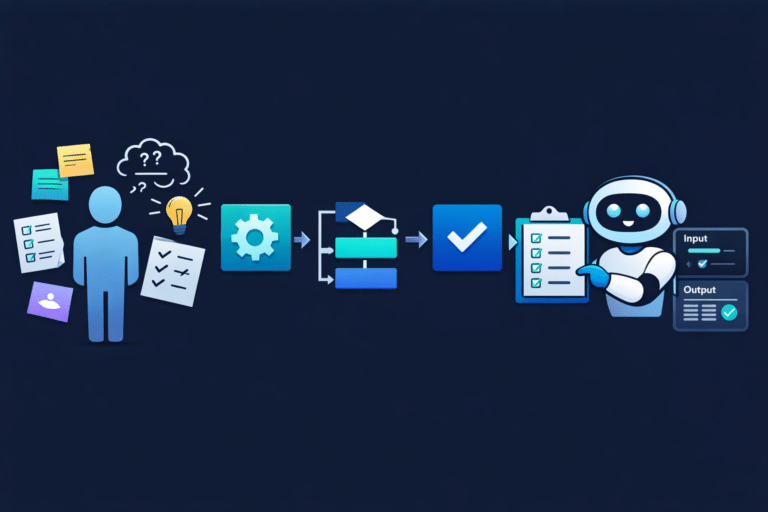

Ejemplo conceptual de diseño

Un agente bien diseñado para gestión de solicitudes:

- Recoge información mínima

- Aplica reglas antes de responder

- Propone acciones, no decisiones finales

- Escala a humano cuando hay conflicto

No necesita ser “inteligente”. Necesita ser comprensible.

Preguntas frecuentes

¿Toda IA es una caja negra?

No. La opacidad suele venir del diseño del sistema, no del modelo en sí.

¿Cuándo es obligatorio un humano en el bucle?

Cuando hay impacto legal, riesgo operativo o decisiones irreversibles.

¿Más reglas significa menos inteligencia?

No. Significa menos improvisación y más control.

¿Se puede empezar simple y escalar?

Sí. De hecho, es la única forma razonable de hacerlo.

Conclusión

Un agente de IA no debería ser una caja negra.

Si no puedes explicar cómo funciona, probablemente no deberías confiar en él.

Diseñar bien desde el principio ahorra problemas después.